本站原创文章,转载请说明来自《老饼讲解-深度学习》www.bbbdata.com

局部响应归一化LRN(Local Response Normalization)出自AlexNet原文

在阅读AlexNet原文时往往需要了解LRN的计算方法,本文形象讲解LRN局部响应归一化是什么

本节介绍什么是局部响应归一化及具体的计算公式

快速了解局部响应归一化是什么

局部响应归一化Local Response Normalization简称为LRN,

它是指将卷积结果按通道进行局部归一化

如下图所示

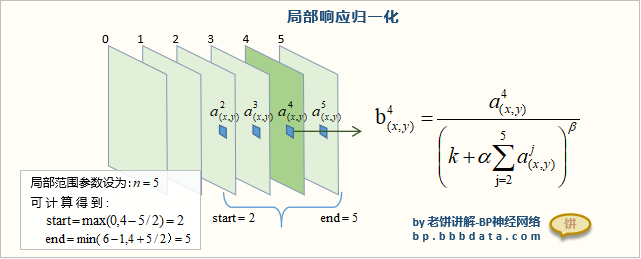

第4通道(x,y)位置的值与邻近通道同位置的值进行一起归一化,从而得到归一化后的值

范围"2->5"是如何确定的?

它由局部范围参数n=5来确定,

由于在第4通道,由以4为中心抓取n=5个通道(即2、3、4、5、6),

但6已经超出通道范围,所以得到"2->5"

局部响应归一化的具体公式

LRN在原文公式如下:

其中

:第i个通道(x,y)位置的值

:第i个通道(x,y)位置归一化后的值

:局部归一化的半径,原文n设为

:通道数,就是通道的最大索引

:待设参数

原文设为

老饼语

AlexNet本身是贡献卓越的,AlexNet中使用的各项技术都因为AlexNet而发扬光大

但唯独AlexNet论文自创的LRN并没有发扬光大,

因为后续的多张论文,使用LRN后都没什么效果,而且计算复杂

因此,LRN基本除了当年AlexNet自身使用,之后基本都没再出现

取而代之的是后来提出的批归一化BN

可以说,LRN完全没有学习的必要,

但为了某些非想知道LRN是什么的同学,所以笔者还是写了本文

End