本站原创文章,转载请说明来自《老饼讲解-机器学习》www.bbbdata.com

GINI系数是CART决策树用于评估树纯度的指标,那GINI系数是怎么来的呢?

本文介绍CART决策树中GINI基尼系数的具体含义,并展示GINI系数的详细推导过程

通过本文,可以更深刻地了解CART决策树中所使用的GINI评估函数是什么

本节介绍决策树中GINI系数的原理及推导过程

GINI系数公式与推导

决策树中使用的GINI公式并非GINI系数的通用形式,

下面我们先介绍GINI系数公式的通用形式

GINI系数公式与含义

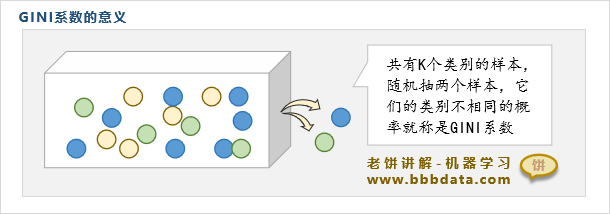

设集合中有K个类别,则称两次抽到不同类别的概率为GINI系数

GINI基尼系数的公式如下:

其中,K是集合的类别个数,代表每次抽到第i类的概率

GINI系数公式的推导过程

第一次抽到Ci类,第二次没抽到 Ci类的概率为:

第一次抽到的可能现象是C1,C2....Ck,则两次抽到不一样的概率:

决策树的GINI系数推导过程

决策树中使用的GINI公式是上述通用GINI系数公式的特殊应用,

决策树中使用的GINI系数公式可在在上述GINI系数公式的基础上进一步推导得到

决策树基尼系数公式的具体推导过程如下:

假设节点上有个样本,属于 类的样本有个

那么抽到类样本的概率为

代入基尼系数的公式,

则易知该节点上的基尼系数表达为

其中

:该节点上的样本数

:该节点上属于 类的个数

它代表在节点上,随机抽两个样本,这两个样本属于不同类的概率

以上就是决策树中的GINI系数的推导过程了

End

评论

评论