本站原创文章,转载请说明来自《老饼讲解-机器学习》www.bbbdata.com

初学机器学习时总会迷惘,本文通过一个简单的的机器学习小例,来展示机器学习是怎么用模型解决问题的

本文展示一个具体的机器学习简单例子,旨在初步认识机器学习,以及机器学习的一些基本概念,

通过本文,可以初步感受机器学习是什么,要干什么,以及机器学习解决问题时的具体建模过程和思路方向

本节展示一个简单的机器学习入门例子

问题

机器学习的主要任务是就是进行预测,例如如下问题

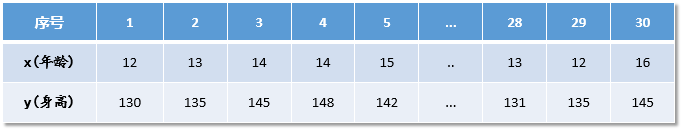

我们有一组年龄与身高的数据

我们希望通过年龄预测身高

下面,我们看看机器学习是如何通过模型来解决这个问题的

Step-1:数据探索EDA

在机器学习建立 模型之前,需要先了解数据的特性

这一步也被称为数据探索(EDA,Exploratory Data Analysis)

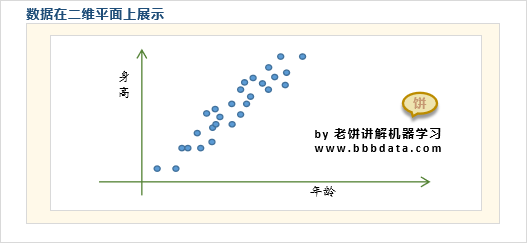

以上述数据为例,只需把x,y画在坐标轴上如下:

可以发现,身高和年龄是有强烈的线性关系的

在实际问题中,数据探索(EDA)会更为复杂,它是机器学习建模中不可缺少的一步

Step-2:选择模型

下面我们看看机器学习是如何建立模型来进行预测的

由于身高与年龄有强列的线性关系,我们可以假设它们的关系是

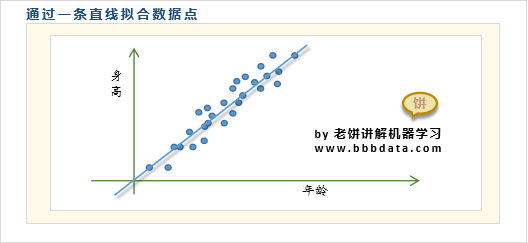

因此本例子可以选择线性模型进行建模,如下:

Step-3:确定模型参数

损失函数

在确定使用线性模型后,就需要确定其中的参数

那么,我们需要的应该是什么样的呢?

在这里,我们希望能令模型预测的结果与实际结果越接近越好

不妨用所有预测样本的误差平方和作为误差的衡量指标

如下

这个用于引导我们求解w,b的函数E,称为模型的 损失函数

注意,机器学习中的损失函数是关于w,b的函数,即设置不同的w,b,就会有不同的误差

损失函数的求解

通过求取令E最小时的[w,b],就能确定最适合我们用来拟合数据点的直线

实际就是求w,b取何值时,能令E 最小的数学问题

如下,令E的偏导数(即分别对w,b求导,多元函数称为偏导,用 符号表示)都为0,

即可联立解得令E最小的w,b。

两个线性方程 ,两个未知数,联立求解即可得到w,b。

本节我们介绍如何对机器学习的模型进行评估

模型评估指标

在求出模型中的参数w,b后,也就是得到了最终的模型之后,

我们还需要评估模型的效果,

机器学习中,一般用模型评估指标(函数)来评估模型的效果

模型评估函数用于衡量模型投入使用时的价值(或者损失)

这个机器学习例子中,我们可以仍然可以使用误差平方和来作为我们最终对模型质量的评估:

当然,我们也可以使用其它函数,具体问题可以具体定义

👉 辨析:模型评估指标与损失函数的异同

模型评估指标与损失函数都一样用于评估模型的质量,

但损失函数是面向求解的,而模型评估指标则面向最后的评估,

初听可能觉得两者一样,其实不一样,

因为损失函数是面向求解的,要求虑到求解的难度等问题,

而模型评估指标则可以更灵活,只需考虑如何评估模型在业务中的效果更为合理就可以

好了,以上就是机器学习的一个入门例子了~

End

评论

评论