本站原创文章,转载请说明来自《老饼讲解-深度学习》www.bbbdata.com

交叉熵损失函数(Cross-Entropy Loss)是机器学习中一种常用于概率预测模型的损失函数

本文讲解交叉熵损失函数的定义以及计算公式,并对公式进行解读,进一步形象理解交叉熵损失函数

通过本文可以了解交叉熵损失函数是什么、它的意义和用途,以及如何计算交叉熵损失函数

本节讲解交叉熵损失函数的定义以及公式解读

什么是交叉熵损失函数

交叉熵损失函数的定义

交叉熵损失函数(Cross-Entropy Loss)是一种常用于概率预测模型的损失函数

交叉熵损失函数是指,基于模型的预测概率,在知道真实标签时的交叉熵

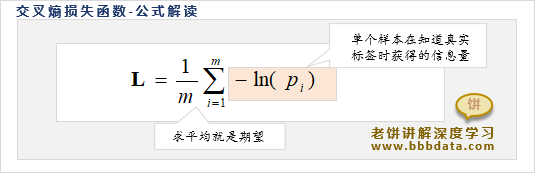

交叉熵损失函数的公式定义如下:

其中,为第i个样本属于真实类别的预测概率,m是样本个数

交叉熵损失函数-公式解读

交叉熵是在认知概率下,得知事实时所获得的信息量期望

交叉熵损失函数则是以模型的预测概率作为基础认知,在知道真实标签时所获得的信息量期望

由于知道样本i的真实标签时,所获得的信息量为

因此,交叉熵损失函数就是所有样本在知道真实标签时所获得的信息量的均值,即期望

交叉熵越小,期望获得的信息量就越小,说明我们对本身事物越掌握,也即模型的预测概率越准确

所以交叉熵损失函数的目的,就是最小化期望信息量,也即最大化模型概率预测的准确程度

交叉熵损失函数的计算公式

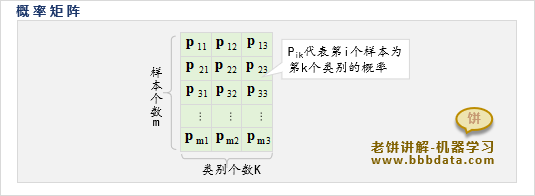

由于我们的预测结果一般是如下的概率矩阵P,其中代表第i个样本属于类别k的概率

因此,往往会将交叉熵损失函数写成如下形式:

其中,为第i个样本属于第k类的概率,k是样本的真实类别

它的意思就是先统计每个类别的样本在知道真实标签时获得的信息量,再对类别求和,并求均值

这是因为类别的数量一般远小于样本数据,计算时先按同一类别计算,更方便程序实现

好了,以上就是交叉熵损失函数的原理与公式了~

End